AnythingLLM. El nombre puede sonar aún poco familiar, pero en el ecosistema creciente de herramientas que buscan llevar el control de la inteligencia artificial al usuario, es uno que apunta a ganar mucho peso. En un momento donde la mayoría de experiencias con modelos de lenguaje ocurren a través de plataformas en la nube, surgen propuestas que plantean una alternativa: ejecutar LLMs de forma local, con privacidad, velocidad y flexibilidad. Y en esa dirección apunta la primera versión de AnythingLLM, una aplicación de escritorio que acaba de lanzarse con el respaldo directo de NVIDIA.

AnythingLLM no es un simple front-end para modelos preentrenados. Se trata de una solución diseñada para integrar flujos de trabajo personalizados con inteligencia artificial, gestionar múltiples fuentes de datos, ejecutar agentes de tipo RAG (generación aumentada por recuperación) y mantener todo este procesamiento en el entorno local del usuario. Puede funcionar como aplicación independiente o integrarse en el navegador, y su arquitectura abierta permite combinar modelos alojados localmente con otros accesibles a través de la nube (como GPT-4 o Claude 3). Todo ello, con una interfaz accesible y un potente sistema de extensiones.

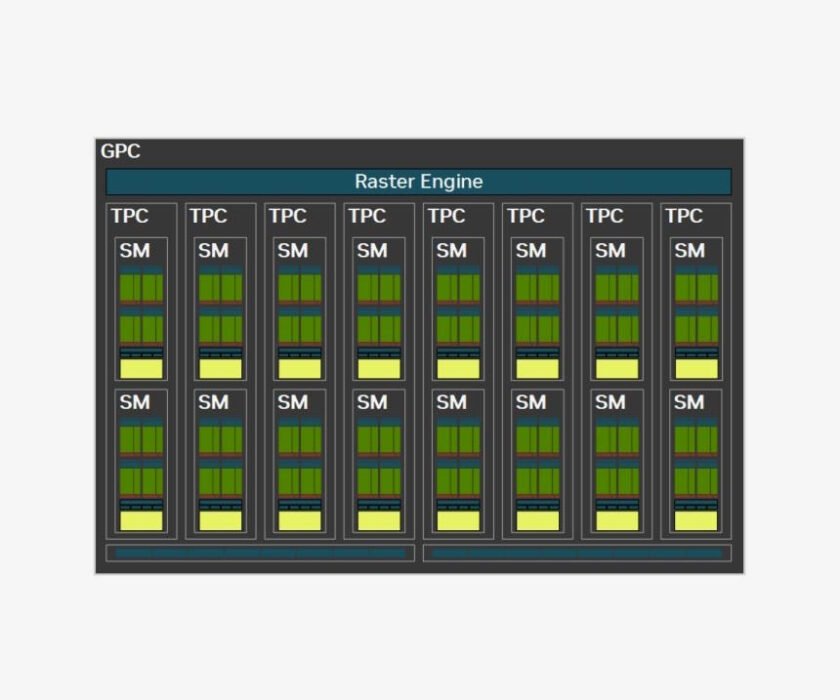

El gran salto, sin embargo, llega ahora con su integración nativa con la plataforma de NVIDIA. Por un lado, el soporte completo para GPUs RTX permite acelerar la ejecución de modelos como Llama 3, DeepSeek o Mistral, con tiempos de respuesta reducidos y mayor capacidad para manejar contextos extensos o tareas complejas. Por otro, la incorporación de los microservicios NIM de NVIDIA abre la puerta a una ejecución más sencilla y optimizada: se trata de contenedores ligeros que encapsulan modelos de IA listos para usar, con compatibilidad inmediata con herramientas como AI Workbench y la posibilidad de integrarlos en flujos automatizados mediante Blueprints.

A nivel técnico, las mejoras son evidentes. Según datos ofrecidos por NVIDIA, una configuración con una GPU RTX 5090 puede ejecutar LLMs como Llama 3.1 8B con una velocidad hasta 2,4 veces superior a un Apple M3 Ultra. Todo ello aprovechando los Tensor Cores de quinta generación y la compatibilidad con frameworks como GGUF, Ollama o Llama.cpp, ampliamente utilizados por la comunidad de IA local. Además, gracias al uso combinado de memoria local y aceleración por hardware, la latencia se reduce significativamente, incluso en sesiones multitarea con agentes concurrentes.

La experiencia no solo mejora en velocidad. Con NIM, AnythingLLM se convierte también en una plataforma más accesible para desarrolladores y empresas. Los modelos se pueden desplegar como microservicios con APIs RESTful, sin necesidad de configuraciones complejas, y el entorno admite la extensión mediante herramientas gráficas como AI Workbench o flujos diseñados en no-code. Esto significa que tanto un desarrollador freelance como un equipo de IT pueden diseñar y desplegar soluciones personalizadas sobre AnythingLLM sin salir de su ecosistema habitual.

En perspectiva, este movimiento consolida la posición de AnythingLLM como uno de los entornos más prometedores para quienes buscan trabajar con IA generativa fuera de los márgenes del SaaS. Su enfoque en la privacidad, el control y la extensibilidad lo convierten en un aliado ideal para usos sensibles o entornos sin conexión, mientras que su nueva compatibilidad con la tecnología de NVIDIA garantiza un rendimiento competitivo a nivel profesional.

Más allá del entusiasmo técnico, lo relevante es el cambio de mentalidad que propuestas como esta apuntalan: la IA no tiene por qué vivir encerrada en los servidores de grandes plataformas. Puede, y quizá deba, avanzar en su salto al escritorio, al entorno del usuario. Porque con herramientas como AnythingLLM, el futuro de la inteligencia artificial también puede escribirse en local.

Más información

La entrada AnythingLLM, NVIDIA da un gran salto en la IA en local se publicó primero en MuyComputer.